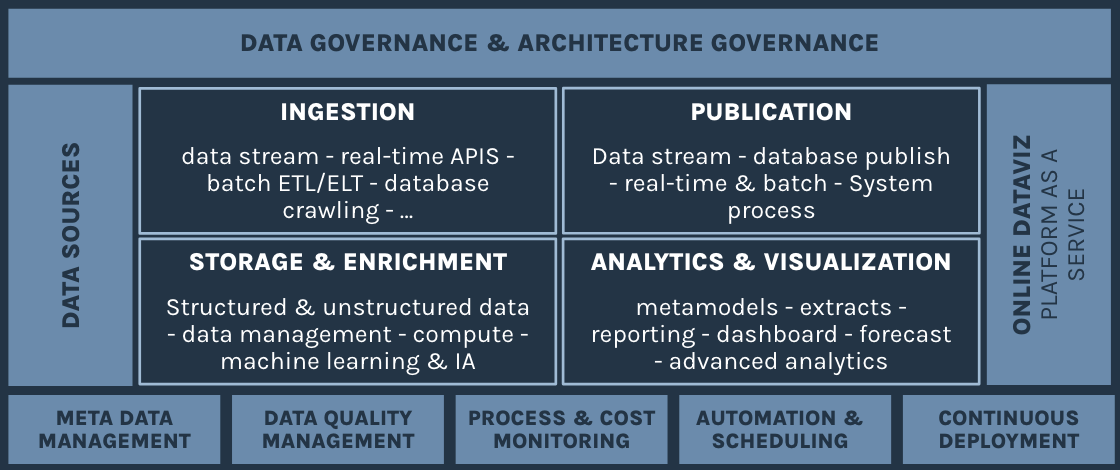

Data Platform

« Analyser, explorer, décider, activer »

- Passer d’une informatique décisionnelle old-school aux Data Platform

- Rassembler et organiser toutes les données structurées et non structurées de l’entreprise

- Accélérer la prise de décision assistée des mécanismes d’IA

- Donner la main aux Métiers pour analyser leurs données de façon libre et exploratoire

- Ré-injecter les données enrichies de la data platform dans les briques opérationnelles du SI

- Accompagnement et mise en place d’une data platform

- Choix de solutions et d’architecture

- Organisation et gouvernance

- Approche data mesh, data product, data catalog, data platform as a service

- Aide à l’exploitation des données (dataviz, reporting, reverse ETL,…)

- Monitoring et optimisation de la data platform

Organisation et gouvernance

La gouvernance des données est un ensemble de processus, de politiques et de contrôles visant à garantir la qualité, la confidentialité, la sécurité et la conformité des données au sein d’une organisation. Cela inclut des éléments tels que la définition des responsabilités, l’établissement de normes et de règles, la gestion des accès, la documentation des métadonnées, la supervision des flux de données, etc.

Lorsqu’on parle de la combinaison entre plateforme de données et gouvernance des données, cela se réfère à l’intégration de pratiques de gouvernance dans la conception, la mise en œuvre et l’utilisation de la plateforme de données, en particulier sur les sujets de sécurité des données, de qualité des données, de conformité règlementaire et de métadonnées

En intégrant la gouvernance des données à la data platform, les organisations peuvent mieux contrôler et gérer leurs données, tout en tirant le meilleur parti de leur potentiel analytique. Cela permet également de garantir que les données sont utilisées de manière responsable et conforme aux exigences réglementaires.

Catalogage des données

Le catalogage des données est le processus de création, de maintenance et de gestion d’un catalogue centralisé de toutes les données disponibles au sein d’une organisation. Ce catalogue agit comme une sorte de référentiel ou de répertoire pour toutes les informations et données stockées dans divers systèmes, bases de données et autres sources au sein de l’entreprise. Il repose entre autres sur des outils de gestion et centralisation des métadonnées pour organiser, trouver et gérer un large volumétrie de données (fichiers, tables,..) : lieu unique, vue complète 360 des bases de données, localisation, profil, statistiques, commentaires, résumés,…

Le but principal du catalogage de données est de permettre aux utilisateurs de trouver, d’accéder et de comprendre facilement les données dont ils ont besoin pour leurs activités commerciales ou leurs analyses. Le catalogue de données fournit des métadonnées décrivant les données, telles que leur origine, leur structure, leur qualité, leur confidentialité, leur propriété, etc. Cela aide à garantir que les données sont utilisées de manière efficace, sécurisée et conforme aux réglementations.

Data mesh / data domains / data product

Les logiques d’une approche DataMesh opèrent un changement de paradigme par rapport aux approches traditionnelles de gestion des données centralisées.

Cela comprend un certain nombre de concepts tels que :

– Data Mesh : décentralisation de la gestion des données au sein d’une organisation en adoptant une approche basée sur les domaines métier. Au lieu d’avoir une équipe centrale de gestion des données, chaque domaine métier est responsable de ses propres données, de leur qualité, de leur gouvernance et de leur utilisation.

– Data Domains : Les domaines de données représentent les différents secteurs fonctionnels ou métiers au sein d’une organisation. Chaque domaine de données est responsable de la collecte, du stockage, du traitement et de l’analyse des données spécifiques à ce domaine. Cette approche favorise la responsabilité et l’expertise des données au niveau local, tout en permettant une meilleure collaboration entre les équipes.

– Data Products : Les produits de données sont des ensembles de données organisés, gérés et mis à disposition comme des produits finis à valeur ajoutée pour les utilisateurs finaux. Ces produits de données peuvent prendre différentes formes, telles que des rapports, des tableaux de bord, des API, des ensembles de données prêts à l’emploi, etc. Chaque domaine de données est responsable de la création et de la gestion de ses propres produits de données pour répondre aux besoins métier spécifiques.

Collecte et intégration des données

– Collecte des données : La collecte des données consiste à rassembler des données depuis différentes sources internes ou externes à l’organisation. Ces sources peuvent inclure des bases de données, des fichiers plats, des capteurs IoT, des API externes, des médias sociaux, des dispositifs mobiles, etc. L’enjeu est l’automatistoin de cette collecte à l’aide de divers outils et technologies, en fonction des besoins spécifiques de l’organisation (stream, temps réel, flux asynchrones, …)

– Intégration des données : une fois les données collectées, il s’agit de les intégrer et consolider pour former un ensemble cohérent, unifié et exploitable ! L’intégration des données implique la transformation, le nettoyage et l’enrichissement des données pour garantir leur qualité et leur cohérence. Cela nécessite de choisir et implémenter les bonnes solutions techniques allant de l’ETL traditionnel (ou aujourd’hui plutôt de l’ELT) aux pipelines de données en continu, etc.

Modélisation, enrichissement, IA

La modélisation des données consiste à concevoir des structures et des schémas qui représentent les données d’une manière qui soit compréhensible et utilisable pour les utilisateurs et les applications.

L’enrichissement des données consiste à améliorer la qualité, la pertinence et la valeur des données en ajoutant des informations supplémentaires à partir de différentes sources. Cela peut inclure des métadonnées, des informations contextuelles, des données géographiques, des données démographiques, etc. L’enrichissement des données peut également impliquer des processus tels que la normalisation, la déduplication, la validation et la correction des données pour garantir leur qualité et leur précision.

En combinant la modélisation des données, l’enrichissement des données et l’intelligence artificielle, les organisations peuvent tirer le meilleur parti de leurs données pour obtenir des informations exploitables, prendre des décisions plus éclairées et créer de la valeur ajoutée.

Exploitation et activation des données (dataviz, reverses eTL)

La datavisualisation vise à rendre les données complexes plus compréhensibles et significatives en les présentant de manière visuelle, sous forme de graphiques, de tableaux, de cartes, de diagrammes et d’autres éléments visuels.

Elle a pour objectif :

– une compréhension facilitée des données plus accessibles pour accéléer l’analyse et la prise de décision.

– l’identification des tendances, les corrélation, et les modèles qui pourraient ne pas être apparents dans les données brutes.

– une communication efficace des insights et des résultats aux parties prenantes.

– une exploration interactive pour approfondir les données et de découvrir des insights supplémentaires.

Il existe de nombreuses solutions de visualisation de données, chacune adaptée à des types de données et des objectifs d’analyse spécifiques.

L’activation opérationnelle des données d’une data platform passe de plus en plus par Le « reverse ETL », concept relativement nouveau qui permet de prendre des données qui résident déjà dans une data platform et de les réinjecter dans les systèmes opérationnels ou les applications métier.

Le reverse ETL est devenu pertinent pour permettre de ramener ces données dans leurs applications et systèmes opérationnels pour les utiliser de manière proactive, par exemple pour personnaliser l’expérience utilisateur, alimenter des tableaux de bord en temps réel, déclencher des actions automatisées, etc.